А вы доверились бы роботу, если бы он был вашим лечащим врачом? Эмоциональные разумные машины могут быть не так далеки от нас, как кажется.

За последние несколько десятилетий, искусственный интеллект существенно прибавил в возможностях чтения эмоциональных реакций людей.

Но читать эмоции — не значит их понимать. Если сам ИИ не может их испытывать, сможет ли он когда-нибудь понять нас в полной мере? И если нет, рискуем ли мы приписывать роботам свойства, которых у них нет?

Последнее поколение искусственного интеллекта уже благодарит нас за рост числа данных, на которых компьютеры могут учиться, а также за увеличение вычислительной мощности. Эти машины постепенно совершенствуются в делах, которые мы обычно отдавали на выполнение исключительно людям.

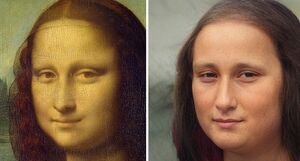

Сегодня искусственный интеллект, среди прочего, может распознавать лица, превращать эскизы лиц в фотографии, распознавать речь и играть в го.

Идентификация преступников

Не так давно ученые разработали искусственный интеллект, который способен сказать, является ли человек преступником, просто посмотрев на его черты лица. Систему оценивали с использованием базы данных фотографий китайцев и результаты вышли просто ошеломляющие. ИИ ошибочно классифицировал невинных людей в качестве преступников всего в 6% случаев и успешно опознал 83% преступников. Общая точность составила почти 90%.

Эта система основана на подходе под названием «глубокое обучение», который оказался успешным, например, в распознавании лиц. Глубокое обучение в сочетании с «моделью вращения лица» позволило искусственному интеллекту определить, представляют ли две фотографии лица одного и того же человека, даже если меняется освещение или угол.

Глубокое обучение создает «нейронную сеть», которая берет в свою основу приближение человеческого мозга. Она состоит из сотен тысяч нейронов, организованных в разных слоях. Каждый слой переводит входные данные, например, изображение лица, на более высокий уровень абстракции, вроде набора ребер в определенных направлениях и расположениях. И автоматически выделяет черты, которые наиболее актуальны для выполнения той или иной задачи.

Учитывая успех глубокого обучения, нет ничего удивительного в том, что искусственные нейронные сети могут отличать преступников от невинных — если действительно существуют черты лица, которые между ними различаются. Исследование позволило выделить три черты. Одна — угол между кончиком носа и уголками рта, который в среднем на 19,6% меньше у преступников. Кривизна верхней губы также в среднем на 23,4% больше для преступников, а расстояние между внутренними уголками глаз в среднем на 5,6% уже.

На первый взгляд, этот анализ позволяет предположить, что устаревшее мнение, что преступников можно определить по физическим атрибутам, не такое уж и неправильное. Тем не менее, это еще не вся история. Что примечательно, две самых релевантных черты связаны с губами, а это наши самые выразительные черты лица. Фотографии преступников, которые использовались в исследовании, требуют сохранять нейтральное выражение лица, но ИИ все же умудрился найти скрытые эмоции на этих фотографиях. Возможно, настолько незначительные, что люди не в силах их обнаружить.

Сложно побороть соблазн взглянуть на образцы фотографий самостоятельно — вот они. Документ еще проходит рецензирование. Тщательное рассмотрение и правда показывает легкую улыбку на фотографиях невинных. Но в образцах не так много фотографий, поэтому сделать выводы о всей базе данных невозможно.

Сила аффективных вычислений

Это не первый раз, когда компьютер способен распознавать человеческие эмоции. Так называемая область «аффективных вычислений» или «эмоциональных вычислений» существует уже давно. Считается, что если мы хотим комфортно жить и взаимодействовать с роботами, эти машины должны уметь понимать и адекватно реагировать на человеческие эмоции. Возможности этой области довольно обширны.

Например, исследователи использовали анализ лиц, чтобы определить студентов, испытывающих трудности с компьютерными обучающими уроками. ИИ научили распознавать различные уровни вовлеченности и разочарования, чтобы система могла понять, когда студенты считают работу слишком простой или слишком сложной. Эта технология может быть полезной для улучшения процесса обучения на онлайн-платформах.

Sony и вовсе пытается разработать робота, способного формировать эмоциональные связи с людьми. Пока не совсем понятно, как она собралась достичь этого или что конкретно будет делать робот. Тем не менее, компания заявляет, что пытается «интегрировать аппаратные средства и услуги, чтобы обеспечить эмоционально сопоставимый опыт».

Эмоциональный искусственный интеллект будет иметь ряд потенциальных преимуществ, будь то роль собеседника или исполнителя — сможет и преступника опознать, и о лечении поговорить.

Существуют также этические проблемы и риски. Будет ли правильным позволить пациенту с деменцией положиться на компаньона в лице ИИ и сказать ему, что он эмоционально живой, хотя на самом деле нет? Сможете ли вы посадить человека за решетку, если ИИ скажет, что он виновен? Конечно, нет. Искусственный интеллект, в первую очередь, будет не судьей, а следователем, определяющим «подозрительных», но уж никак не виновных людей.

Субъективные вещи вроде эмоций и чувств сложно объяснить искусственному интеллекту, отчасти потому, что у ИИ нет доступа к достаточно хорошим данным, чтобы объективно их проанализировать. Сможет ли ИИ когда-нибудь понять сарказм? Одно предложение может быть саркастичным в одном контексте и совершенно другим — в другом.

В любом случае, объем данных и вычислительной мощности продолжает расти. За несколькими исключениями, ИИ вполне может научиться распознавать различные типы эмоций в ближайшие несколько десятилетий. Но сможет ли он когда-нибудь сам их испытывать? Это спорный вопрос.

Другие новости по теме:

published on according to the materials

Запись взята с сайта .

Комментарии (0)